Всем привет! Даже достаточно совершенные алгоритмы гугла нуждаются в ручном вмешательстве и в этой статье речь пойдет про инструмент disavow-links-main.

После выхода алгоритма Пингвин и получения так называемых писем счастья в гугл панели многие оптимизаторы почувствовав на себе проседание трафика бросились исправлять ситуацию и начали снимать покупные ссылки, менять анкоры и тд. В итоге некоторые даже сделали хуже, потеряв позиции и в яндексе. Исходя из реалий современного интернета, недобросовестной конкуренции и прочего был выпущен инструмент disavow-links-main, позволяющий указать поисковику на те ссылки, которые по мнению вебмастера негативно влияют на сайт и мешают ему правильно ранжироваться.

Сам инструмент находится по адресу:

https://www.google.com/webmasters/tools/disavow-links-main

Инструмент получился достаточно спорный. Но с другой стороны допустим ваш конкурент решил вас «потопить» ссылочным взрывом и наставил ссылок с гавносайтов и сайт улетает под фильтр, то вполне разумно воспользоваться данным инструментом и снизить до нуля влияние этих ссылок. Но работает ли он на практике?

Это и попробуем сделать с помощью… данного блога. Как вы уже заметили, статьи тут достаточно редко затачиваются под ключевики и в основном это просто авторский текст с минимальной долей оптимизации. До пингвина трафик с гугла на блог составлял где-то 60%, при чем в ТОПе были такие относительно сочные запросы как СЕО БЛОГ, SEO БЛОГ, SEO — теперь же ситуация в корне поменялась и по этим запросам ТОП в яндексе, а в гугле все печально. Вот пример трафика за вчера:

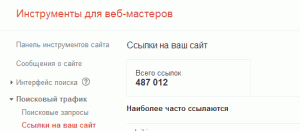

Собственно гуглу есть за что сердиться, тут и покупные ссылки и ссылки с шаблонов и прогоны и еще куча всякой всячины. Естественных ссылок отсилы штук 80-100 и то с SEO форумов и блогов. Что же я попробую сделать?

Для начала выгружу ВСЕ ссылки, которые выдаст ЯНДЕКС вебмастер, для тех кто не в курсе, нужно поставить вот такую галочку:

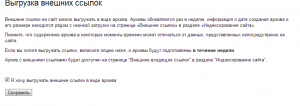

Затем ссылки также будут экспортированы из панели вебмастера google:

Затем спарсена вся выдача по запросам вида:

seoonly.ru

https://seoonly.ru

«https://seoonly.ru/»

«seoonly.ru»

и тд

5-7 поисковых систем. Далее все ссылки будут объединены в один большой файл и встанет вопрос, а что с этим добром делать?

****

ТУТ МОГЛА БЫТЬ ВАША РЕКЛАМА СЕРВИСОВ И СОФТА ДЛЯ ПРОВЕРКИ ТРАСТА САЙТА

****

Есть 4 пути:

- Руками проверить все сайты, визуально оценить их качество и тд и отобрать «плохие ресурсы».

- Забить все это дело в программы для оценки траста или сервисы и по условной величине «траста» ниже среднего отобрать «плохие сайты» и загнать их в инструмент гугла

- Сделать экспресс анализ на число страниц в поиске, ТИЦ, PR и уже по этим параметрам отсеять сайты. Скажем больше 100 страниц в индексе, PR отличный от нуля, ТИЦ>10.

- Положить болт на все это дело — сделать постобработку ссылок, удалить дубликаты и тупо все домены без разбора вогнать в список для отклонения ссылок.

Пока я склоняюсь к 4 варианту, но есть вопросы — как это повлияет на сайт, обнулится ли PR, пропадет ли весь трафик или увеличится? Ответов пока нет.

К слову сказать файлик с нежелательными ссылками можно загружать лишь 1, но его можно редактировать. Ссылки я с блога уже как полтора года не продаю, трафик с гугла сейчас смешной, так что почему бы и не рискнуть?

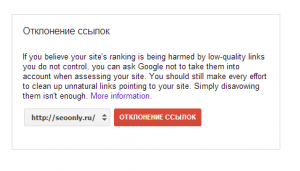

После прочтения важного предупреждения, которое можно сформулировать одной фразой — » не сделай хуже «:

можно приступать к добавлению. Конструкция достаточно простая, либо ссылка на страницу, где размещена ссылка ( вот такая тавтология), либо :

domain:domain.com

Соответственно будет дано указание не учитывать все ссылки с конкретного домена, это как раз мой случай и файлик будет подготовлен именно в таком формате. Далее просто необходимо загрузить .TXT документ и ждать…

Как отразится отклонение ~85-90% всей ссылочной массы сайта сказать сложно. Эффект судя по всему стоит ожидать не раньше 3-4 недель. Посмотрим что из этого выйдет.

Подписывайтесь на блог, ставьте лайки : )

Всем хорошего дня!

У Яндекса в этом плане проще — он попросту не учитывает купленные ссылки, вот и всё. И это верно, ведь иначе конкуренты могут навредить добросовестным ресурсам.

Очень правильно что вы дали ссылку на этот инструмент, я только по прямой ссылке в него и захожу. Меня всегда мучал один вопрос: до инструмента отклонния ссылок можно добраться через меню в кабинете веб-мастеров?

Я его там ни разу не замечал, хотя ему там самое место…

При беглом осмотре также не нашел

тоже какой раз ищу ) приходится в нете шукать при необходимости

Тоже пытался когда-то так вылечить сайт. Терпения хватило на 2 месяца и удалил файлик, т.к. результата не было, а стах на изменение PR тоже был.

Читал тогда разговоры забугорных товарищей. Пишут, что работает, но сроки восприятия гошей могут быть до года.

Посмотрим-)

Пишут, что работает

У тебя как успехи?

Точно точно, в месте где написано «ТУТ МОГЛА БЫТЬ ВАША РЕКЛАМА СЕРВИСОВ И СОФТА ДЛЯ ПРОВЕРКИ ТРАСТА САЙТА»

Что касается эксперимента, то Серега Кокшаров уже проводил его — просто взял и все беклинки со своего блога загрузил. При этом ему было чем рисковать, у него трафик серьезный со всех ПС. В результате — ничего не изменилось… Совсем ничего.

Посмотрим, что у будет в результате этого эксперимента!

ЗЫ программу мб ближе к НГ прикуплю

Если от xtool и отпишутся, то только чтобы меня дерьмом поливать и тут

ЗЫ покупай, есть еще время подумать

Эффекта не будет. Проверено до вас уже давным давно. К стати, по поводу сетки сайтов. Вот, написал сегодня мини статью о том, откуда можно ежедневно вытаскивать огромные пачки качественного контента. Проверено. Если автоматизировать, то трафик польется рекой 100%.

Идея норм, вообще переводчики украинский — русский и обратно достаточно хорошо переводят. Вот с автоматизацией конечно туго. Когда-то давно я пытался сделать сайт на украинском с помощью гугл переводчика) в индекс яшки так и не вошел, но тут можно попробовать, но опять же надо на фриланс топать и парсер заказывать с бюджетом 150-250 вмз

Я помню пользовался автоматическим наполнением статей с разных сайтов. Так вот этот сайт тоже не был индексирован яндексом. Нужно как можно более уникализировать контент. Сейчас я вставляю в тексты уникальные картинки минимум.

С чего бы это не будет эффекта. Сам удалял ссылки таким образом, правда отразилось это через 2 месяца, и то, не все убранные мною ссылки отпали. У меня как раз была ситуация с тем что конкуренты прогнали мой сайт вообще по спамным словам. После того как ссылки начали отваливаться — позиции подросли.

Да таким способом (через Вики) можно получать уникальный текст с любых сайтов на всех языках мира… Чуть правишь перевод для читабельности и вуаля